1 基于无人机载荷的目标检测方法

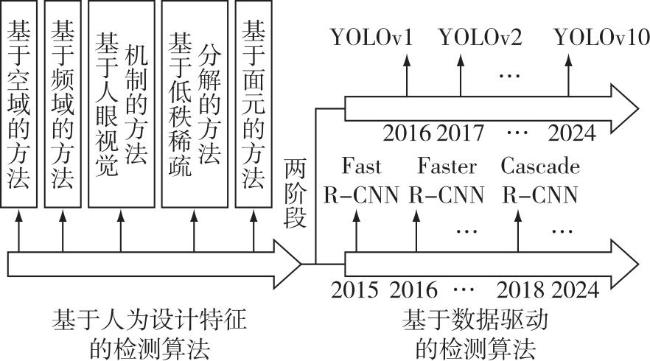

1.1 目标检测方法概述

1.2 红外目标检测

表1 基于人为设计特征的无人机载荷红外目标检测方法总结Tab.1 Summary of infrared target detection algorithm for UAV payloads |

| 类别 | 代表性方法 | 文献 | 特点 | 局限性 |

|---|---|---|---|---|

| 均值滤波器 | [12] | 计算速度快,计算复杂度低 | 需要较高的图像信噪比,仅适用于简单且均匀的背景,复杂背景或干扰条件下性能差 | |

| 基于空域处理 | 中值滤波器 | [13] | ||

| 形态学滤波器(Top-hat) | [14] | |||

| 小波变换 | [15] | 对复杂动态变化背景中的噪声敏感 | 目标快速移动或变形情况下算法适应性较差 | |

| 基于频域处理 | 频域高阶统计量 | [16] | ||

| 谱尺度空间 | [17] | |||

| 基于人眼 视觉机制 | LCM | [18] | 利用人眼视觉机制进行目标检测 | 背景突出时杂波和目标特征相似,难以区分,降低检测性能 |

| ILCM | [19] | |||

| NLCM | [20] | |||

| MPCM | [21] | |||

| RLCM | [22] | |||

| 基于低秩 稀疏分解 | 基于矩阵的方法 | [23-24] | 适用于各种复杂、迅速变化的背景,利用部分时空特征信息 | 多帧方法耗时,时空特征信息利用不充分 |

| 基于张量的单帧方法 | [25-26] | |||

| 基于张量的多帧方法 | [27] | |||

| FODD | [28] | 对于某些特定类型的图像背景具有较好的检测效果 | 复杂环境下算法适应性低 | |

| 基于面元模型 | SODD | [29] | ||

| DECM | [30] |

中国指挥与控制学会会刊

中国指挥与控制学会会刊