指控系统是指挥机构和人员对作战武器装备和有关作战人员进行指挥控制的信息系统

[1],人机交互是指挥员与信息装备进行双向信息交换的过程,当前舰艇指控系统主要基于图形用户界面进行人机交互,采用摸球、键盘、触摸屏等进行信息输入,界面复杂,嵌套多,指挥人员需要在不同的操控界面之间反复切换,才能完成某一操控任务,这增加了操作响应时间。在舰艇实际作战过程中,指挥人员和指控系统操作人员一般严格按照作战条令条例执行作战任务。繁杂的操作界面和种类繁多的操作指令给操作人员带来认知负担和心理压力,使其难以适应紧张、快节奏的操作负荷。随着信息技术的高速发展,虚拟、增强现实以及语音、手势、体感等新型自然人机交互技术在指控系统的应用成为可能,依靠多通道自然人机交互的指挥手段

[2],将指挥员从繁杂的操作中解脱出来,对于减轻指挥和操作人员认知负担和操作压力,提高作战指挥效率,具有重要意义。

交互效率广泛应用于人机交互和工效学研究中,主要包括用户在执行任务时的时间和准确率。近年来,国内外结合虚拟、增强现实技术,将语音、手势、体感等人机交互技术应用到电子沙盘

[3-4]、指挥控制系统

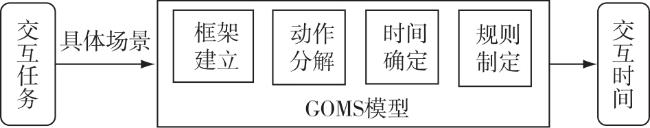

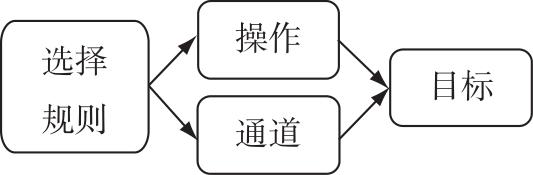

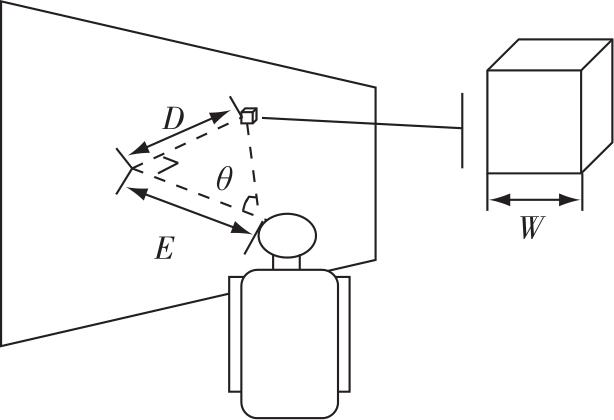

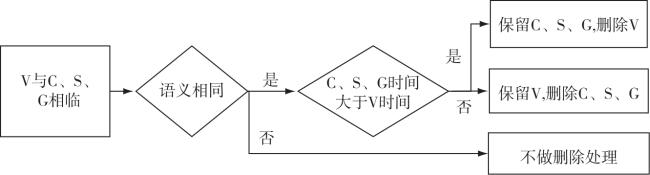

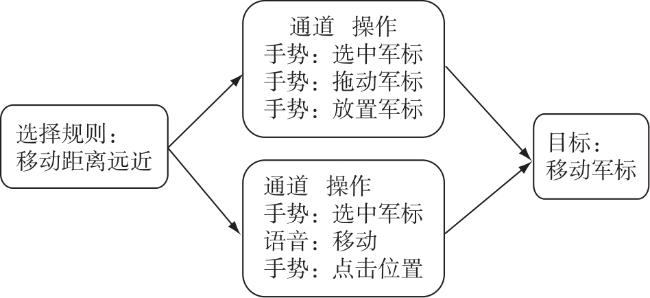

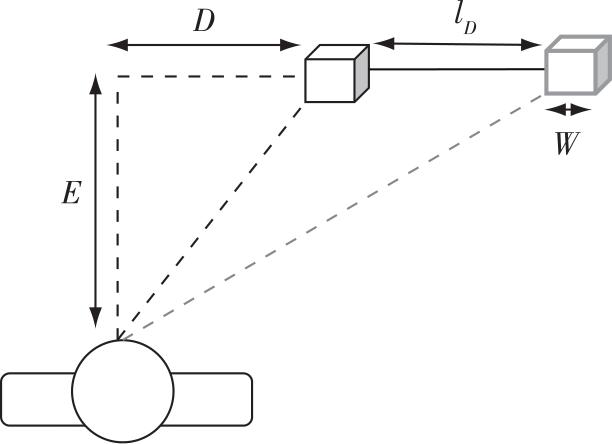

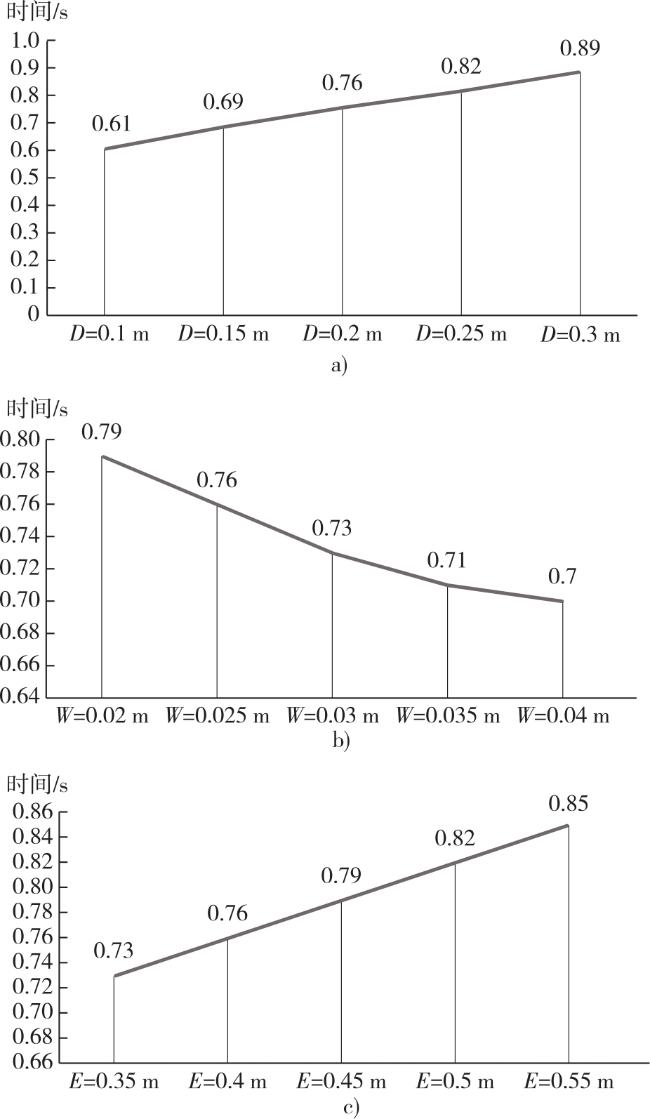

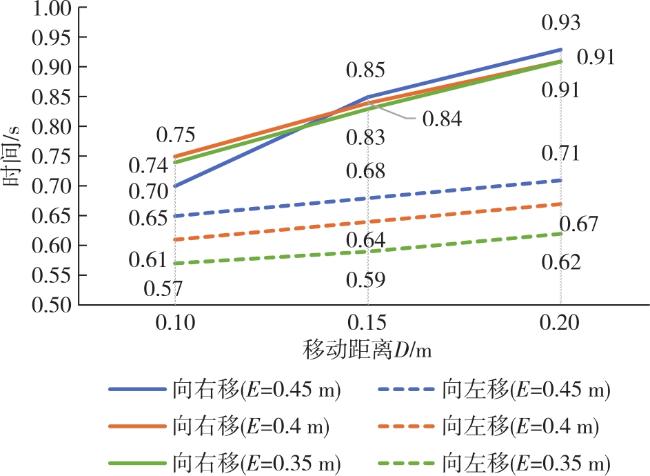

[5-6]等领域,并优化各项交互技术以提高交互准确率,但没有对交互时间的预测与分析,缺少针对这些场景的交互效率评估研究。执行语音手势的交互时间、交互方式都与使用摸球、键盘交互有所不同,需要定性定量的分析方法对此进行交互效率评估。针对这一问题,本文在分析传统二维图形用户界面GOMS交互效率评估的基础上,提出了一种面向增强现实指挥的人机交互GOMS模型,该模型结合增强现实环境下三维界面、语音交互、手势交互等特点进行改进设计,建立与作战指挥任务相适应的分析模型,分析不同阶段人机交互方式使用时间及不同交互场景对交互操作时间的影响,预测用户完成任务所需的时间,量化不同交互方式的绩效,为交互系统优化设计提供依据和参考。

中国指挥与控制学会会刊

中国指挥与控制学会会刊